NVIDIA, Microsoft và Ingrasys đã cùng nhau công bố bộ gia tốc GPU dựa trên Tesla P100 – HGX-1 Hyperscale GPU Accelerator. Hệ thống mới này có khả năng gia tốc theo cấp số nhân trong điện toán đám mây/trí tuệ nhân tạo và dựa trên thiết kế mã nguồn mở với sự kết hợp của dự án Project Olympus của Microsoft.

NVIDIA và Microsoft công bố giải pháp HGX-1 Hyperscale GPU Accelerator trang bị nhiều card Tesla P100 dành cho trí tuệ nhân tạo và điện toán đám mây.

NVIDIA đã đạt được một số thành công trong việc thâm nhập vào ngành công nghiệp trí tuệ nhân tạo. Trong quý trước, các báo cáo về thị phần máy trạm của NVIDIA tăng 15% so với năm tài chính trước đó. Trong Q4 năm 2016, thị trường cơ sở dữ liệu ghi nhận mức tăng 93 tỉ đô la Mỹ và dự đoán năm tài khóa 2017 doanh thu có thể đạt 296 tỉ đô. Đây là một thành công ấn tượng cho công ty trong phân khúc thị trường này và việc họ dồn lực vào phát triển GPU hiệu suất cao dành cho việc tăng tốc trí tuệ nhân tạo, DNN và công nghệ điện toán đám mây đã thu được trái ngọt.

HGX-1 được dành cho các tác vụ xử lý trí tuệ nhân tạo dựa trên đám mây. Nó thiết lập một tiêu chuẩn công nghiệp có thể sẽ nhanh chóng được chấp nhận khi nhu cầu thị trường đang tăng cao.

Kiến trúc mới được thiết kế để đáp ứng nhu cầu khai thác điện toán trí tuệ nhân tạo trên mây – trong các lĩnh vực như xe hơi tự lái, chăm sóc sức khỏe cá nhân, nhận dạng giọng nói, phân tích dữ liệu, mô phỏng phân tử và video. Jen-Hsun Huang, sáng lập và CEO của NVIDIA đã nói: “Trí tuệ nhân tạo là một mô hình tính toán mới đòi hỏi một kiến trúc mới”.

Bộ gia tốc GPU HGX-1 thực thi trí tuệ nhân tạo trên mây như cách mà chuẩn ATX đã làm trên PC trước đây. Nó cho phép các nhà cung cấp dịch vụ đám mây dễ dàng hơn trong việc tiếp cận GPU NVIDIA để đáp ứng các nhu cầu ngày càng tăng trong điện toán trí tuệ nhân tạo” bởi NVIDIA.

“Bộ gia tốc HGX-1 mang đến hiệu suất tuyệt vời để đám ứng các đòi hỏi trước sự tăng trưởng mạnh mẽ của các tiến trình học thuật, với thiết kế độc quyền cho phép dễ dàng trang bị nó trong các trung tâm dữ liệu trên toàn thế giới” trích dẫn lời của Kushagra Vaid, giám đốc và kỹ sư trương bộ phận Azure Hardware Infrastructure tại Microsoft thông qua bài đăng trên blog của NVIDIA.

Đối với hàng ngàn doanh nghiệp và các công ty mới thành lập trên toàn thế giới đang đầu tư vào lĩnh vực trí tuệ nhân tạo và áp dụng các phương pháp tiếp cận dựa trên trí tuệ nhân tạo, kiến trúc HGX-1 cung cấp các cấu hình và hiệu suất chưa từng có trong đám mây.

Bộ gia tốc GPU HGX-1 có sức mạnh như thế nào?

Được trang bị đến 8 GPU NVIDIA Tesla P100 trong mỗi chassis, với một giải pháp chuyển mạch đầy tính cách mạng được thiết kế dựa trên công nghệ kết nối NVIDIA NVLink và chuẩn PCIe, cho phép một CPU tự động kết nối đến bao nhiêu GPU tùy ý. Việc này cho phép các nhà cung cấp dịch vụ đám mây tiêu chuẩn hóa hạ tầng trên HGX-1 để cung cấp cho khách hàng một loạt các cấu hình dựa trên CPU và GPU.

Việc xử lý đám mây đang rất đa dạng và phức tạp hơn bao giờ hết. Việc đào tạo các trí tuệ nhân tạo, hội nghị và các khối lượng công việc trên HPC vận hành một cách tối ưu trên các cấu hình khác nhau, với một CPU gắn liền với một số các GPU khác nhau. Thiết kế dạng modular cơ động cao của HGX-1 cho phép thực hiện việc tối ưu mà không cần biết đến số lượng các công việc. Nó cung cấp khả năng học thuật chuyên sâu nhanh hơn 100 lần so với các máy chủ dựa trên nền tảng máy chủ cũ, và ướt tính chi phí cho việc huấn luyện AI chỉ chiếm 1/5 và chỉ 1/10 chi phí cho việc kết nối các AI lại với nhau.

Với sự linh hoạt của nó để có thể làm việc với các trung tâm dữ liệu trên toàn cầu, HGX-1 cho phép mở rộng các trung tâm dữ liệu đã có một cách nhanh chóng, đơn giản để sẳn sàng cho các AI.

| Tesla Products | Tesla K40 | Tesla M40 | Tesla P100 |

|---|---|---|---|

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) |

| SMs | 15 | 24 | 56 |

| TPCs | 15 | 24 | 28 |

| FP32 CUDA Cores / SM | 192 | 128 | 64 |

| FP32 CUDA Cores / GPU | 2880 | 3072 | 3584 |

| FP64 CUDA Cores / SM | 64 | 4 | 32 |

| FP64 CUDA Cores / GPU | 960 | 96 | 1792 |

| Base Clock | 745 MHz | 948 MHz | 1328 MHz |

| GPU Boost Clock | 810/875 MHz | 1114 MHz | 1480 MHz |

| Compute Performance – FP32 | 5.04 TFLOPS | 6.82 TFLOPS | 10.6 TFLOPS |

| Compute Performance – FP64 | 1.68 TFLOPS | 0.21 TFLOPS | 5.3 TFLOPS |

| Texture Units | 240 | 192 | 224 |

| Memory Interface | 384-bit GDDR5 | 384-bit GDDR5 | 4096-bit HBM2 |

| Memory Size | Up to 12 GB | Up to 24 GB | 16 GB |

| L2 Cache Size | 1536 KB | 3072 KB | 4096 KB |

| Register File Size / SM | 256 KB | 256 KB | 256 KB |

| Register File Size / GPU | 3840 KB | 6144 KB | 14336 KB |

| TDP | 235 Watts | 250 Watts | 300 Watts |

| Transistors | 7.1 billion | 8 billion | 15.3 billion |

| GPU Die Size | 551 mm² | 601 mm² | 610 mm² |

| Manufacturing Process | 28-nm | 28-nm | 16-nm |

NVIDIA gia nhập dự án Open Compute Project

NVIDIA đang gia nhập vào tổ chức Open Compute Project để hỗ trợ thúc đẩy sự phát triển các AI và các trung tâm dữ liệu. Công ty dự kiến sẽ tiếp tục hợp tác với Microsoft và Ingrasys và các thành viên khác để thúc đẩy nền tảng máy tính sẳn sàng cho các nhà cung cấp dịch vụ đám mây và các khách hàng của các trung tâm cơ sở dữ liệu khác.

NVIDIA và Fujitsu xây dụng một siêu máy tính AI dựa trên 24 đơn vị NVIDIA DGX-1s, lên đến 192 mô đun Tesla P100

Nền tảng DGX-1s dựa trên Tesla P100 của NVIDIA đã được sử dụng để cung cấp sức mạnh cho siêu máy tính RIKEN. Siêu máy tính này được dành riêng cho viện nghiên cứu toàn diện lớn nhất Nhật Bản, chuyên nghiên cứu về AI và học thuật chuyên sâu.

Đây là một khách hàng lớn nhất của DGX-1S hiện nay, siêu máy tính này sẽ đẩy nhanh việc ứng dụng trí tuệ nhân tạo để giải quyết các thách thức phức tạp trong chăm sóc sức khỏe, sản xuất và an toàn công cộng.

Jen Hsu Huang, CEO NVIDIA đã nói trên blog của NVIDIA: “DGX-1 giống như một cỗ máy thời gian dành cho việc nghiên cứu trí tuệ nhân tạo. Các doanh nghiệp, các trung tâm nghiên cứ và các trường đại học trên thế giới đang ứng dụng DGX-1 để vượt qua các làn sóng học thuật chuyên sâu – một bước đột phá về công nghệ ở trung tâm của cuộc các mạng về trí tuệ nhân tạo”

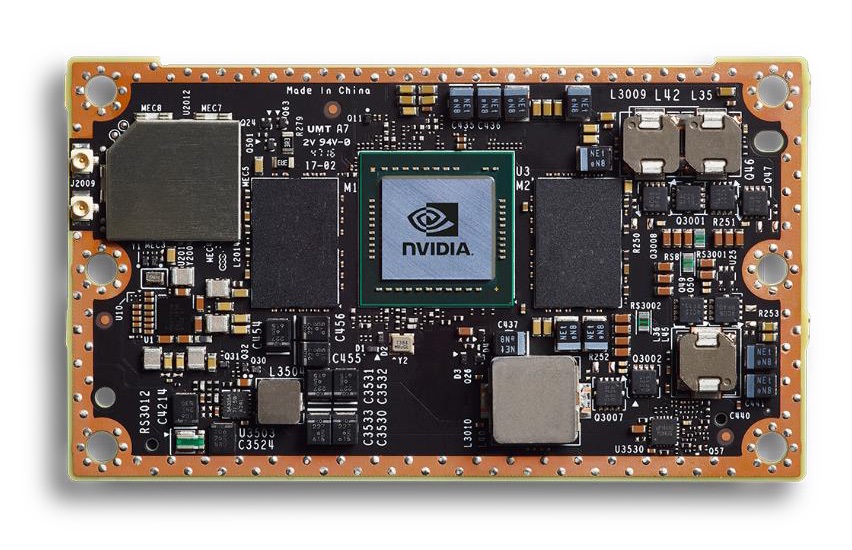

Siêu máy tính Jetson AI của NVIDIA được nâng cấp lên nền tảng Pascal với phiên bản Rev.TX2

NVIDIA cũng công bố siêu máy tính Jetson TX2 với việc trang bị các GPU dựa trên kiến trúc Pascal. Siêu máy tính AI giờ đây sẽ được trang bị sức mạnh của các nhân xử lý từ GPU Pascal trong một đóng gói chỉ tiêu thụ 7.5W điện.

Về cấu hình, Jetson TX2 bao gồm một GPU Pascal kết hợp cùng một CPU Denver 2 64-bit và A75, bộ nhớ LPDDR4 8GB 128-bit độc lập trên bo mà sẽ cho băng thông lên đến 58,4GB/s. Băng thông này là tăng gấp đôi so với bo Jetson TX1. Về lưu trữ cũng tăng gấp đôi với 32GB eMMC.

Jetson TX2 sẽ gia nhập cùng với TX1 và TK1 dành cho các hệ thống nhúng. Jetson là một nền tảng mở. Do đó, nó phù hợp cho những ai có ý định tận dụng các AI tiên tiến để làm việc “ở rìa”, hoặc trong các thiết bị trong thế giới xung quanh chúng ta. Jetson TX2 tăng gấp đôi hiệu năng so với người tiền nhiệm, hoặc nó có thể vận hành với mức hiệu quả trong điện năng gấp hai lần, trong khi tiêu tốn chỉ 7,5W điện năng.

Hiện bộ Jetson TX2 Developer Kit đã có thể đặt mua tại Mỹ và châu Âu với giá 599$, và sẽ được giao sau ngày 14 tháng Ba.